La première moitié de 2025 a été une période transformative pour Databricks, avec la société lançant une série d'annonces majeures de fonctionnalités qui signalent son ambition de dominer le « stack » de données moderne. Des capacités serverless aux analyses alimentées par l'IA, ces releases mettent en avant des améliorations évolutives ainsi que de nouvelles approches révolutionnaires en ingénierie et analytics des données.

Alors que certains concurrents se concentrent sur des composants individuels, Databricks mise clairement sur une approche d'écosystème intégré. La question pour les équipes de données est de savoir si ces nouvelles capacités tiennent leurs promesses – et lesquelles sont prêtes à être utilisées en production aujourd'hui.

Cette analyse couvre les annonces clés de la première moitié de l'année – avec une attention particulière sur le Data + AI Summit de cette année, qui a vu la concentration la plus élevée de mises à jour (tanto les annonces largement publicisées que celles publiées discrètement, comme les améliorations d'Auto Loader, le nouveau connecteur Google Sheets, les workspaces serverless et la tâche dbt Cloud dans le Workflow).

Je couvrirai également l'état actuel de ces fonctionnalités : ce qui est disponible aujourd'hui, ce qui fonctionne bien, et ce qui continue d'évoluer.

Lakeflow Connect – Unified Data Ingestion

Peut-être la déclaration la plus complète était Lakeflow Connect, représentant la tentative de Databricks de standardiser l'ingestion de données sur l'ensemble de l'écosystème. Il ne s'agit pas seulement d'ajouter davantage de connecteurs – il s'agit de créer une expérience unifiée qui élimine la complexité de la gestion de multiples pipelines de données.

Lakeflow Connect est l'écosystème unifié de Databricks pour ingérer des données provenant pratiquement de toute source – stockage cloud, bases de données, applications SaaS ou tables Delta existantes.

Il se compose de trois principaux composants :

Auto Loader

Declarative Pipelines

Managed Connectors

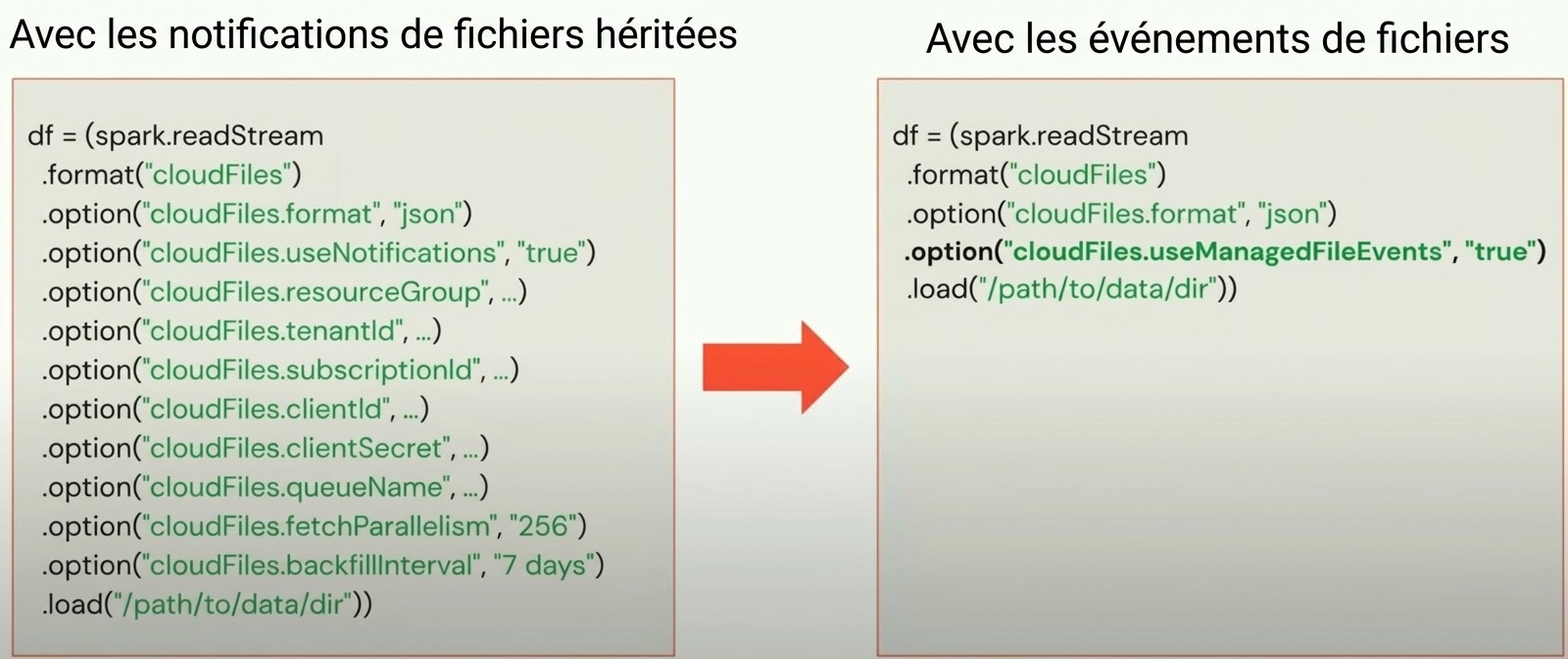

Auto Loader : Améliorations des fonctionnalités clés incluent :

Ingestion plus simple avec les nouveaux événements de fichier : pas besoin de créer des files d'attente séparées pour chaque flux.

Credit : Databricks

Gestion du cycle de vie des fichiers : Vous pouvez désormais archiver ou supprimer automatiquement les fichiers source en fonction d'une période de rétention définie

Connexion directe vers un emplacement SFTP

Deux nouveaux formats de données : XML et Excel

Évolution du schéma : Ajout de nouvelles colonnes avec élargissement de type

Déclarative pipelines :

Delta Live Tables (DLT) a été rebrandé sous Lakeflow comme Declarative Pipelines, désormais positionné comme une capacité centrale dans l'écosystème Databricks.

Les nouvelles fonctionnalités clés incluent :

Interface utilisateur / IDE améliorées conçues pour les flux de travail d'ingénierie des données

Support multi-schéma

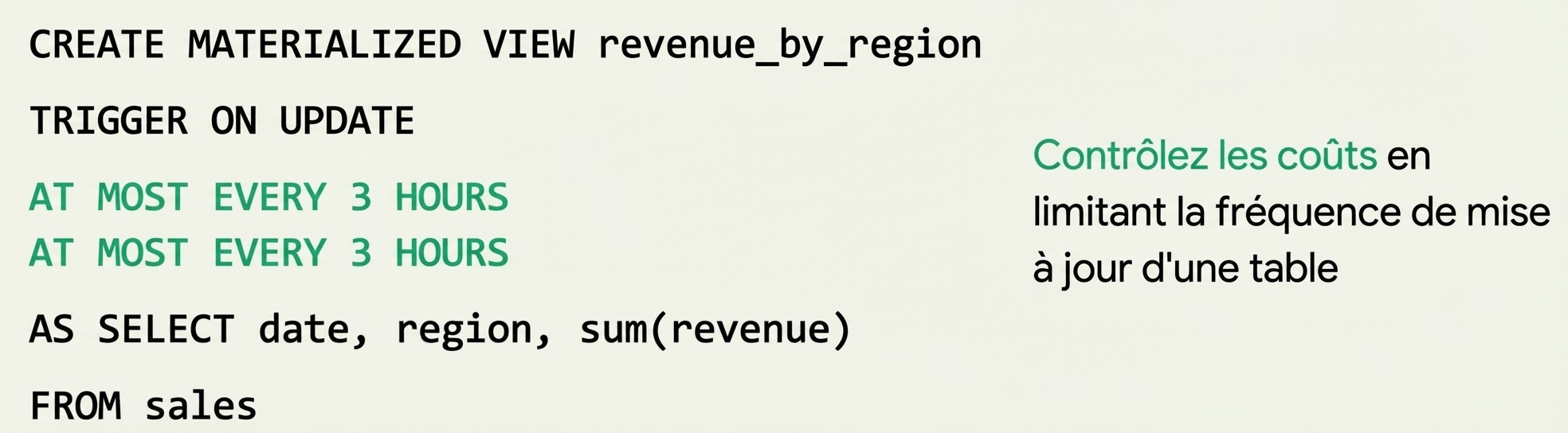

Enzyme pour les vues matérialisées

Intégration transparente avec les Connecteurs gérés

Auto CDC remplace Apply_Changes pour les opérations SCD1 ou SCD2

Déclencheur sur mise à jour pour les vues matérialisées au lieu de planifier manuellement

Credit : Databricks

Un designer No-Code Lakeflow a été présenté dans le keynote, permettant la création de pipelines glisser-déposer avec assistance IA. Cependant, cette fonctionnalité n'a pas encore été publiée.

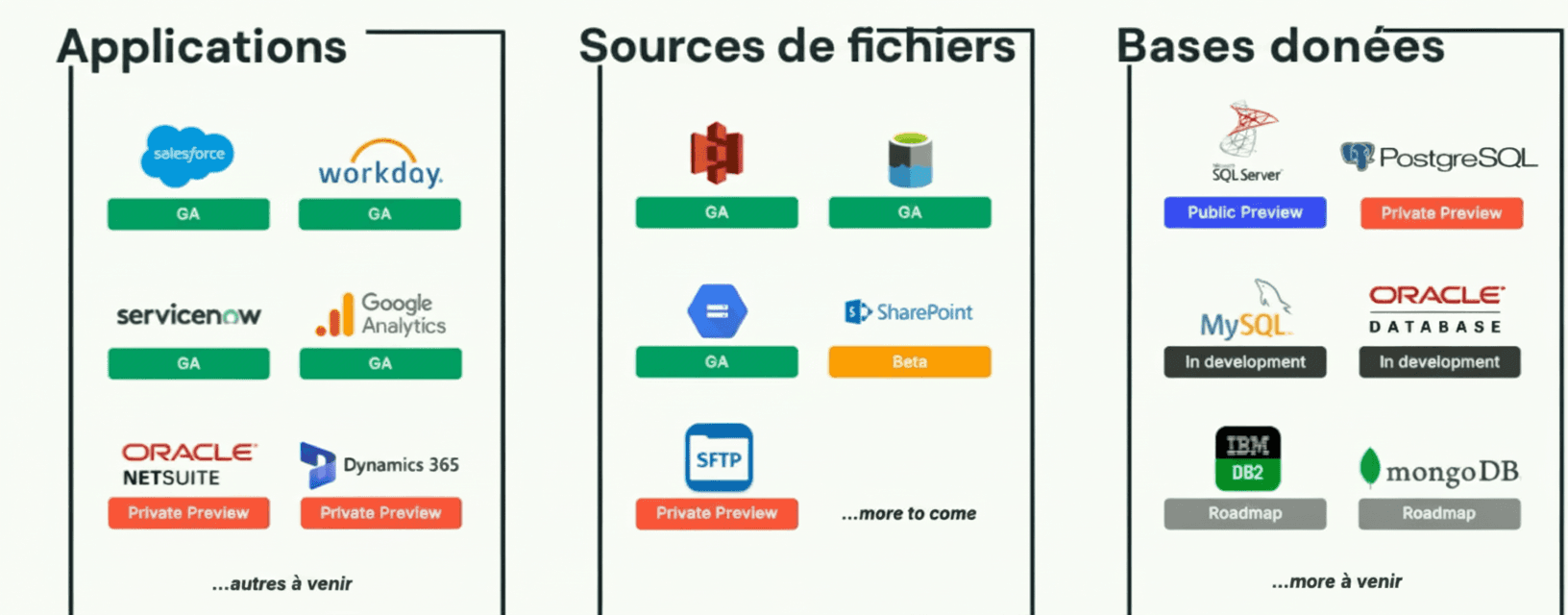

Lakeflow Connect Managed Connectors

Vous pouvez désormais vous connecter facilement à une large gamme de sources de données en utilisant les connecteurs gérés Lakeflow Connect – qu'il s'agisse de bases de données relationnelles comme SQL Server et PostgreSQL, ou de plateformes SaaS comme Salesforce. Certains de ces connecteurs gérés prennent déjà en charge des fonctionnalités avancées telles que Slowly Changing Dimensions (SCD Type 1 et Type 2) dès la sortie de la boîte.

Un certain nombre de connecteurs sont généralement disponibles, tandis que d'autres sont en prévisualisation privée ou font partie de la feuille de route à venir.

Credit : Databricks

À venir : Ce qui arrive

Query Pushdown : Poussez le filtrage et la logique de transformation vers le système source pour réduire le mouvement de données et améliorer significativement les performances.

Filtrage au niveau de la ligne et masquage des colonnes : Appliquez des contrôles d'accès de données granuleux en vol pour protéger les informations sensibles comme le PII.

Support de connecteurs étendu : Nouveaux connecteurs pour les plateformes comme Snowflake, Amazon Redshift, MySQL et Google BigQuery sont en pipeline.

Lakebase – Serverless Postgres with OLTP/OLAP

Au-delà de l'ingestion de données, Databricks a fait un pas audacieux vers l'espace database avec Lakebase. Lakebase est le résultat de l'acquisition de Neon par Databricks. Databricks a introduit une base de données Postgres serverless entièrement gérée qui combine les capacités OLTP et OLAP dans un seul système. Elle dispose d'un stockage et d'un calcul séparés, permettant une grande scalabilité et des performances élevées.

Pour répondre aux problèmes de latence bien connus avec le stockage d'objets comme S3 et Azure Blob, Databricks a ajouté une couche de cache intermédiaire qui stocke l'état doux. Cela permet aux requêtes de contourner les chemins de stockage lents et de viser directement le cache, réduisant la latence d'environ 100 ms à seulement 10 ms.

Fonctionnalités non prises en charge dans Lakebase encore :

Serverless Compute : La surveillance des coûts est essentielle car actuellement, le calcul ne se redimensionne pas automatiquement à zéro lorsqu'il n'est pas utilisé.

Branching (Copy on Write) : Permet des clones instantanés et économes en stockage de votre base de données. Vous n'engagez pas de frais de stockage tant que vous ne commencez pas à apporter des modifications. C'est idéal pour les expérimentations et les tests.

Credit : Databricks

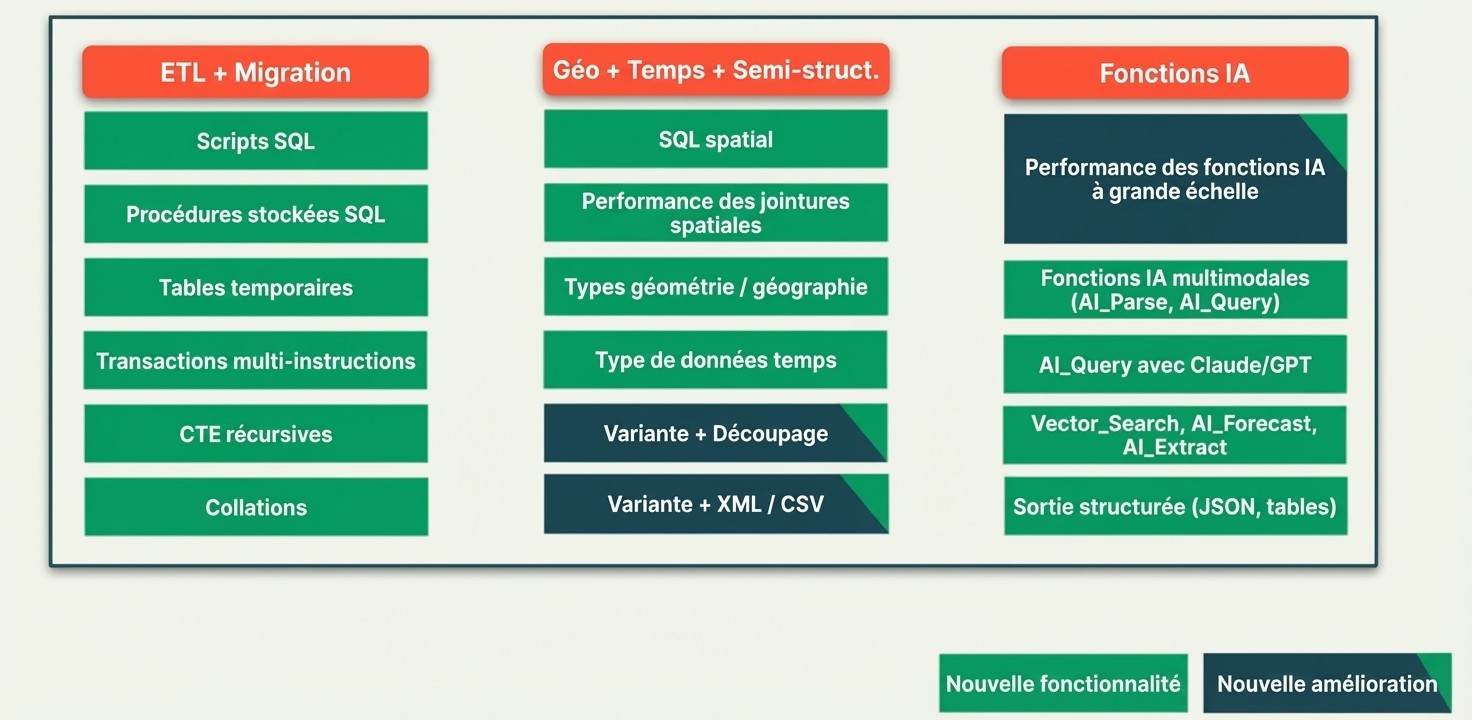

Databricks SQL

Sur le plan SQL, Databricks continue de combler le fossé entre l'entrepôt de données traditionnel et l'analytics moderne. Les ajouts ici sont particulièrement pertinents pour les équipes migrantes depuis des systèmes hérités ou celles qui préfèrent des flux de travail centrés sur SQL.

Les ajouts clés incluent :

Nouvelles fonctions IA comme AI_Extract, Vector_Search, AI_Query

Stored Procs : Idéal pour les personnes à l'aise avec l'entrepôt hérité. Beaucoup plus puissant que les UDFs.

Énoncés multi-transactions supportant l'optimistic concurrency et la concurrence au niveau de la ligne.

Credit : Databricks

Databricks AI/BI Dashboards

Les améliorations des tableaux de bord AI/BI montrent l'engagement de Databricks à démocratiser l'analytics des données. Ces fonctionnalités sont conçues pour réduire la barrière technique pour les utilisateurs métier tout en fournissant la profondeur dont les analystes ont besoin.

AI Forecasting (Beta) : Ajoutez des aperçus prédictifs directement à vos tableaux de bord en utilisant des modèles de prévision intégrés.

Top Driver Analysis (Private Preview) : Met en évidence automatiquement les facteurs clés influençant les tendances et anomalies dans vos données.

Genie Deep Research : Prévu pour la sortie plus tard cet été, Genie apportera des aperçus contextuels profonds et une analyse guidée aux workflows BI.

Drill-Through Capability (Private Preview) : Permet aux utilisateurs d'explorer les détails sous-jacents de données de manière interactive.

BI and Partner Tools

Un des aspects les plus pratiques de ce Data + AI Summit de cette année était l'accent mis sur l'intégration avec les outils existants. Au lieu de forcer les utilisateurs à abandonner leurs flux de travail actuels, Databricks les rencontre où ils se trouvent – dans Excel, Google Sheets, Power BI et Tableau.

Run dbt Cloud Jobs in Workflows (Private Preview) : Intégrez les tâches dbt directement dans les workflows Databricks pour une orchestration de bout en bout.

Power BI Task in Workflows : Lancé plus tôt cette année, permettant des rafraîchissements automatiques de rapports Power BI dans le cadre des workflows Databricks.

Simplified Tableau Cloud Connectivity : Connectez facilement à Tableau Cloud en quelques étapes avec des guides et des outils mis à jour.

Arrow Database Connectivity for Power BI (Coming Soon) : Promet un transfert de données plus rapide et plus efficace pour les gros modèles et les tableaux de bord en temps réel.

Databricks Connector for Google Sheets : Récupérez facilement des données en direct de Databricks dans Google Sheets pour une analyse et un reporting collaboratifs.

Pour moi, le Databricks Connector for Google Sheets était l’une des annonces les plus marquantes. Il facilite grandement l'accès aux données pour les utilisateurs métier sans devoir dépendre de tooling complexe ou de l'équipe technique.

Et attendez, il y a plus : un connecteur pour Microsoft Excel est également coming soon, qui renforcera encore plus les utilisateurs métier en portant les données Databricks dans leurs outils les plus familiers.

Databricks Free Version and Serverless Workspaces

Un drapeau de tambour, s'il vous plaît ! Databricks propose désormais une version gratuite pour tout le monde. Il s'agit d'une mise à jour importante par rapport à l'offre d'essai précédente, qui était limitée à 14 jours et 40 $ de crédits – ce que j'épuisais souvent en deux jours. En comparaison, Snowflake propose un essai de 30 jours avec 400 $ de crédits.

Il s'agissait peut-être de la déclaration la plus démocratique, car elle introduit une vraie tranche gratuite. Et il ne s'agit pas seulement d'une poussée marketing – c'est une stratégie pour mettre Databricks entre les mains des développeurs individuels et des petites équipes qui pourraient devenir des clients d'entreprise plus tard.

Ce qui a ressorti lors du paramétrage était à quel point l'expérience est devenue sans friction. Avec les workspaces serverless, je n'ai plus besoin de configurer des identifiants ou des emplacements de stockage externe. Tout est géré en coulisses.

LakeBridge – Legacy ETL Migration

Pour les organisations disposant d'investissements ETL hérités importants, LakeBridge représente un changement potentiel majeur. Au lieu de forcer une réécriture complète, il promet d'automatiser une grande partie du processus de migration – bien que, comme toute boîte à traduction automatisée, les résultats nécessiteront probablement une supervision humaine.

LakeBridge est le résultat de l'acquisition de Bladebridge par Databricks, maintenant rebaptisé et intégré dans leur écosystème.

Credit : Databricks

Il est conçu pour analyser et convertir le code ETL hérité en PySpark ou SQL moderne, selon le langage source. Il inclut également des capacités de validation pour garantir que la logique traduite fonctionne comme prévu. Databricks revendique une précision de conversion de 70 % et travaille activement à l'améliorer.

Actuellement, LakeBridge est un outil basé sur CLI, mais Databricks travaille activement sur une version basée sur UI pour le rendre plus accessible et convivial.

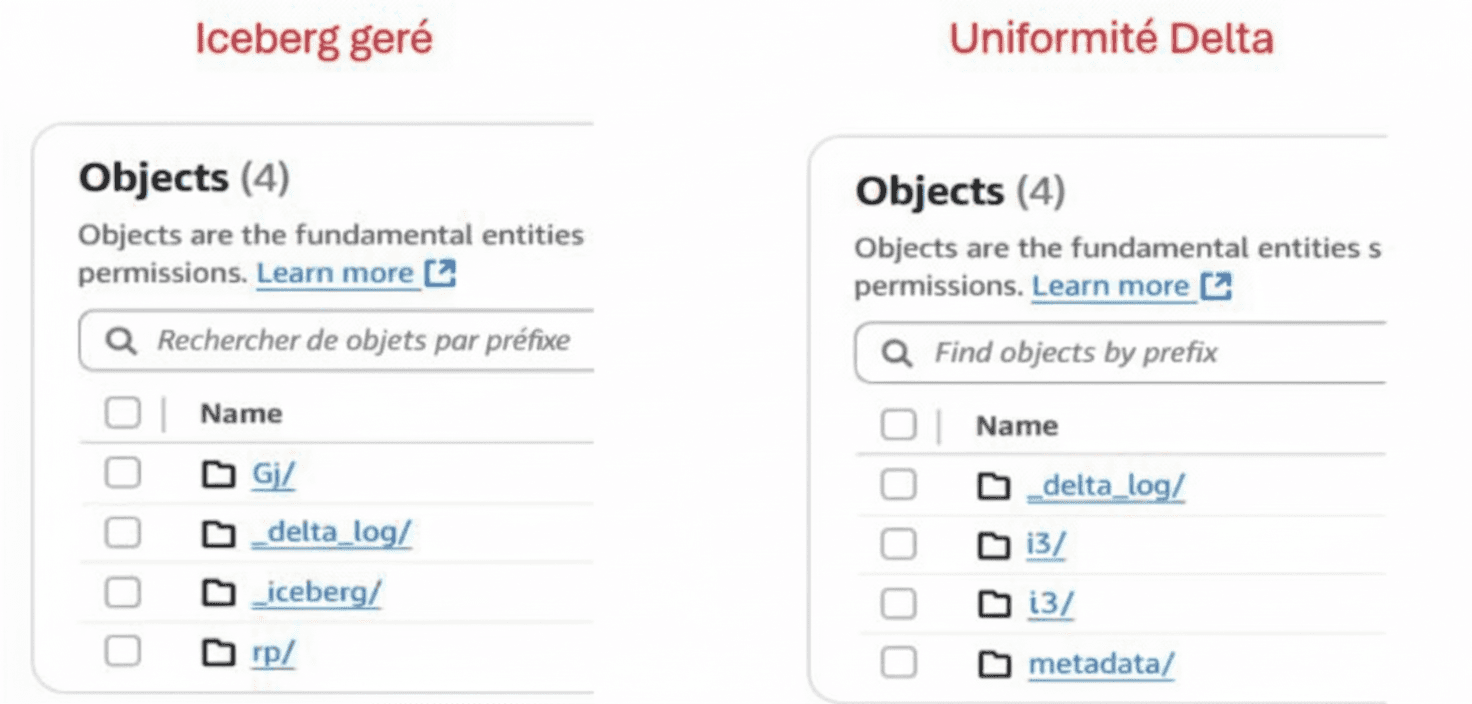

Managed Iceberg Tables

Dans les guerres de format entre Delta Lake et Apache Iceberg, Databricks adopte une approche pragmatique. Au lieu de forcer les utilisateurs à choisir, ils fournissent une interopérabilité – un mouvement intelligent qui réduit les coûts de commutation et les inquiétudes de verrouillage fournisseur.

Cette fonctionnalité apporte une véritable interopérabilité à Databricks.

Les tables Iceberg gérées génèrent des métadonnées compatibles avec les formats Delta et Iceberg, vous permettant d'accéder à vos données de manière transparente sur plusieurs moteurs de requête.

Si vous utilisez d'autres systèmes compatibles Iceberg, vous pouvez désormais lire/écrire vers les mêmes tables, sans conversion complexe.

Metrics View

Le concept de couche sémantique n'est pas nouveau, mais l'implémentation de Databricks semble se concentrer sur la simplicité et l'accessibilité pour les utilisateurs métier. Cela peut être particulièrement précieux pour les organisations qui peinent à maintenir la cohérence des métriques entre différents outils et équipes.

Metrics View sert de couche logique définie au-dessus de vos ensembles de données, où chaque métrique ou KPI est centralement défini et géré. La beauté c'est que les utilisateurs métier peuvent également créer et comprendre des métriques sans écrire de requêtes complexes.

Elle devient votre source unique de vérité pour l'analytics, garantissant la cohérence entre tableaux de bord, rapports et équipes. Dans l'ensemble, c'est un ajout puissant pour une BI fiable et gratuite.

Quelques points à retenir avec Metrics View :

Actuellement, elle n'a pas d'intégration complète avec tous les outils BI. Elle fonctionne avec Omni et Databricks AI/BI. Vous pouvez également exploiter des API pour récupérer les métriques.

Autres annonces de fonctionnalités notables incluent :

Agentbricks

Multi Agent Supervisor

Managed MCP Servers

Managed MLflow Prompt Registry

Je couvrirai chacun de ces éléments en détail dans les prochains posts du blog.